最小二乗法

scipyを使用して実際の問題である最小二乗法を解決し、結果をグラフ化します。

まず、scipyと必要なライブラリをインポートします。

1 | import numpy as np |

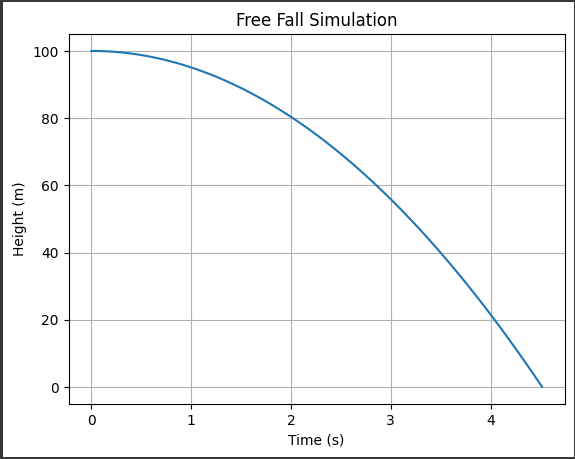

次に、データを作成します。ここでは、実際の問題として、ある物体の自由落下の時間と距離の関係を考えます。

1 | time = np.array([0.1, 0.2, 0.3, 0.4, 0.5, 0.6, 0.7, 0.8, 0.9, 1.0]) |

次に、最小二乗法を使用してデータをフィットさせる関数を定義します。

1 | def linear_func(x, a, b): |

最小二乗法を実行し、最適なパラメータを取得します。

1 | params, params_covariance = curve_fit(linear_func, time, distance) |

結果をグラフ化します。

1 | plt.scatter(time, distance, label='Data') |

これにより、データポイントに最も適合する直線が表示されます。

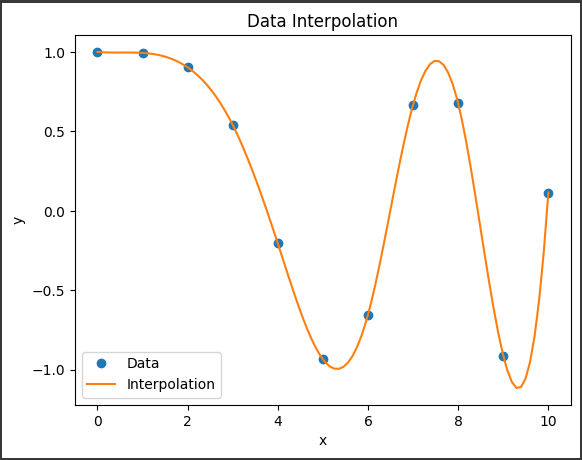

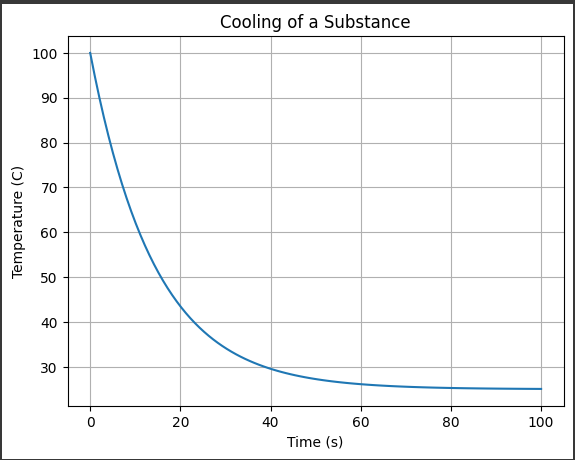

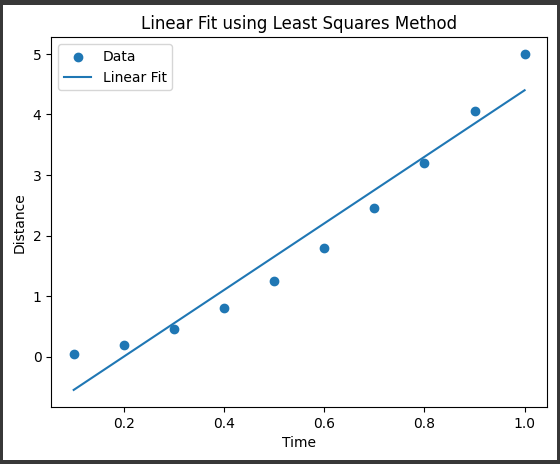

グラフ解説

このグラフは、時間と距離の関係を示しています。

x軸は時間を表し、y軸は距離を表しています。

データポイントは青い点で表示されており、それぞれの点は実際の観測値を表しています。

また、青い線は最小二乗法によってフィットされた回帰直線を表しています。

この回帰直線は、データポイントに最も適合する直線を表しており、時間と距離の関係を近似的に表現しています。

回帰直線の傾きと切片は、最小二乗法によって求められた最適なパラメータです。

傾きは直線の傾きを表し、切片はy軸との交点を表しています。

これらのパラメータは、時間と距離の関係を数値的に表現するために使用されます。

このグラフを通じて、時間と距離の関係を視覚的に理解することができます。

データポイントが回帰直線に近い位置にある場合、回帰直線がデータによく適合していることを示しています。

逆に、データポイントが回帰直線から離れている場合、回帰直線がデータに適合していないことを示しています。

このようなグラフを使用することで、時間と距離の関係を視覚化し、傾向やパターンを把握することができます。

また、回帰直線を使用することで、未知の時間における距離を予測することも可能です。