気候データの予測

Prophetを使用して気候データの予測を行うことは一般的です。

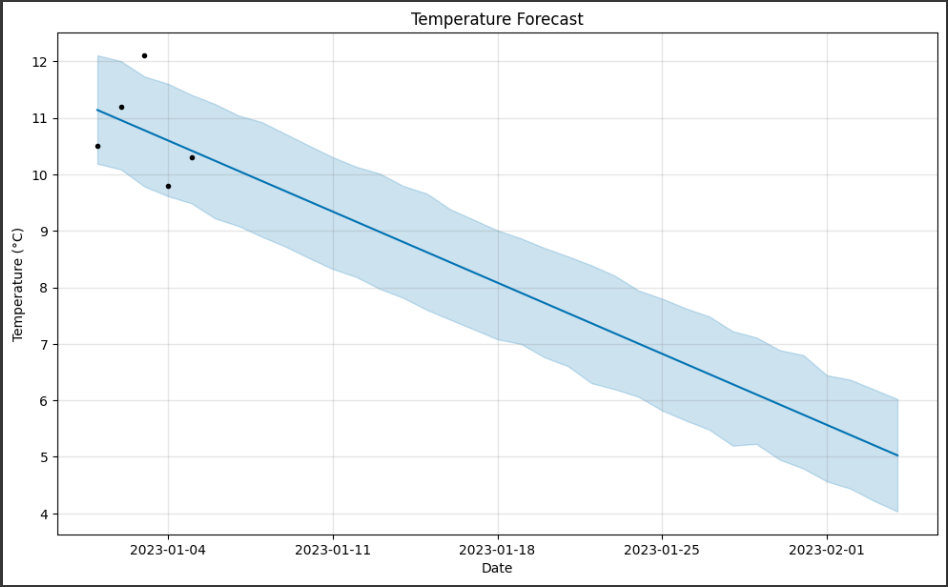

以下は、気温の予測を例に示します。

Prophetを使用して気温データを予測し、結果をグラフ化する方法です。

1 | # 必要なライブラリをインポート |

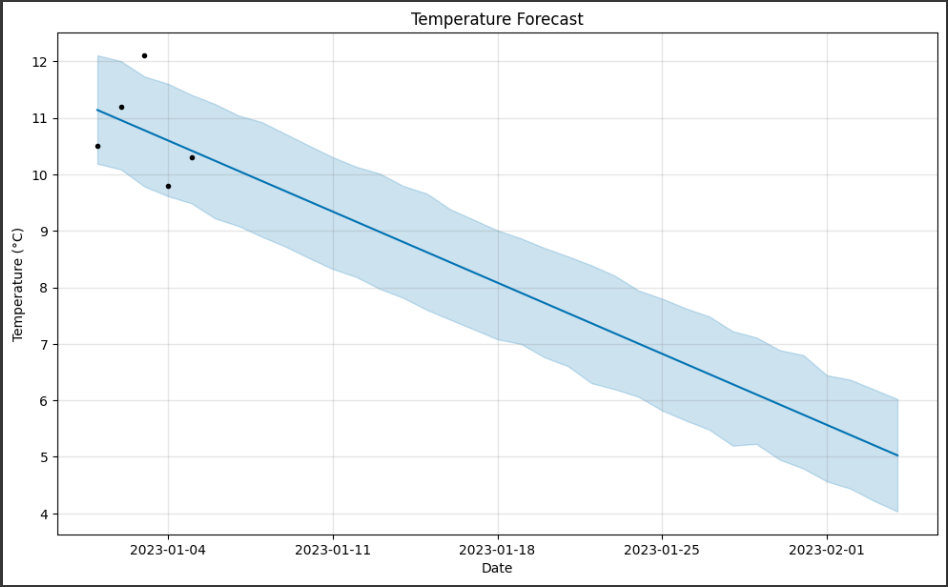

この例では、5日間のサンプル気温データを使用してProphetモデルを訓練し、将来の30日間の気温を予測しています。

ソースコード解説

以下は、ソースコードの各部分の詳細説明です。

1. 必要なライブラリをインポートします:

pandas: データを扱うためのライブラリ。Prophet: 時系列データの予測を行うためのProphetモデルを提供するライブラリ。matplotlib.pyplot: グラフを描画するためのライブラリ。

2. サンプル気温データを定義します:

dataデータフレームには、日付 (ds) と気温 (y) の2つの列があります。

これはProphetモデルに渡すためのサンプルデータです。このサンプルでは、5つの日付とそれに対応する気温が提供されています。

3. Prophetモデルを作成します:

Prophet()コンストラクタを使用してProphetモデルを作成します。

4. データに適合させます:

model.fit(data)を呼び出して、Prophetモデルを提供されたデータに適合させます。

これにより、モデルはデータのトレンドや季節性を学習します。

5. 予測用の未来の日付を生成します:

model.make_future_dataframe(periods=30)を呼び出して、将来の日付を含むデータフレームを生成します。

periodsパラメータは、いくつの未来の日付を生成するかを指定します。

この例では30日間の未来の日付を生成しています。

6. 予測を実行します:

model.predict(future)を呼び出して、未来の気温を予測します。

この予測結果はforecastデータフレームに格納されます。

7. 予測結果をグラフ化します:

model.plot(forecast)を呼び出して、予測結果をグラフ化します。

x軸に日付、y軸に気温が表示され、青い線は予測された気温のトレンドを表し、灰色の領域は予測の信頼区間を示します。

また、グラフにタイトルと軸ラベルも追加されています。

このソースコードはProphetを使用して気温データの予測を行い、結果をグラフで視覚化する基本的なスクリプトです。

データと期間を変更すれば、他の時系列データに対しても同様の予測を行うことができます。

グラフ解説

Prophetによって生成されたグラフは、時間軸に沿った気温データの予測とその信頼区間を示しています。

以下に、このグラフの詳細を説明します。

1. 黒いポイント:

黒いポイントは実際のデータポイントです。

2. 青い線:

青い線はトレンドの予測の一部で、気温の変動のトレンドを表します。

3. 水色の領域:

水色の領域は予測の信頼区間を示しています。

通常、Prophetは予測の不確実性を示すためにこの信頼区間を提供します。

水色の領域の幅が広ければ広いほど、不確実性が高いことを示します。

4. x軸 (Date):

時間軸は日付を示しており、過去のデータから将来の日付に向かって予測が行われています。

5. y軸 (Temperature):

y軸は気温を示しており、単位は摂氏度(°C)です。これは気温の値が表示されます。

このグラフは、Prophetモデルによる気温の予測を視覚化するためのものであり、予測された気温のトレンド、季節性、信頼区間などを理解するのに役立ちます。

例えば、将来の日付における気温の予測傾向や変動の不確実性を把握することができます。