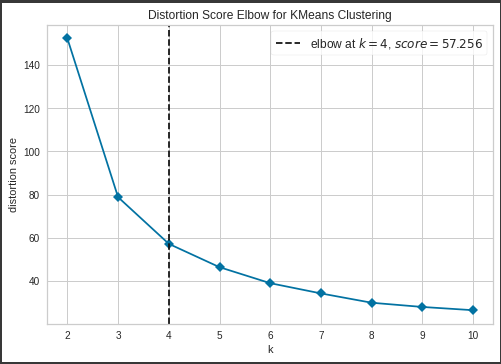

エルボー図

前回構築したクラスタリングモデルのエルボー図を表示します。

[Google Colaboratory]

1 | plot_model(kmeans, plot = "elbow") |

[実行結果]

急激に変化している箇所を最適なクラスタ数と判断することができます。

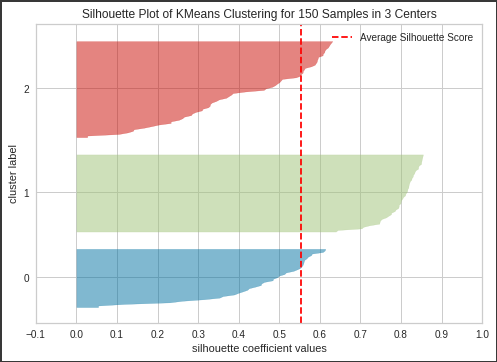

シルエット図

次にシルエット図を表示します。

[Google Colaboratory]

1 | plot_model(kmeans, plot = "silhouette") |

[実行結果]

各バーの縦幅が同じくらいになっていれば均等に分割できていると判断することができます。

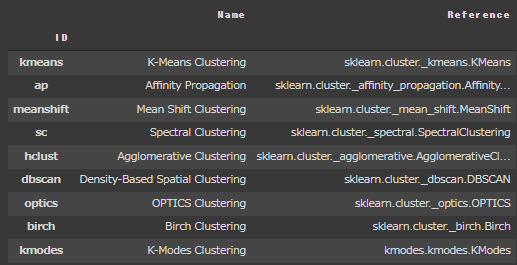

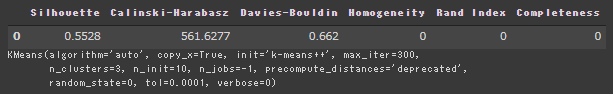

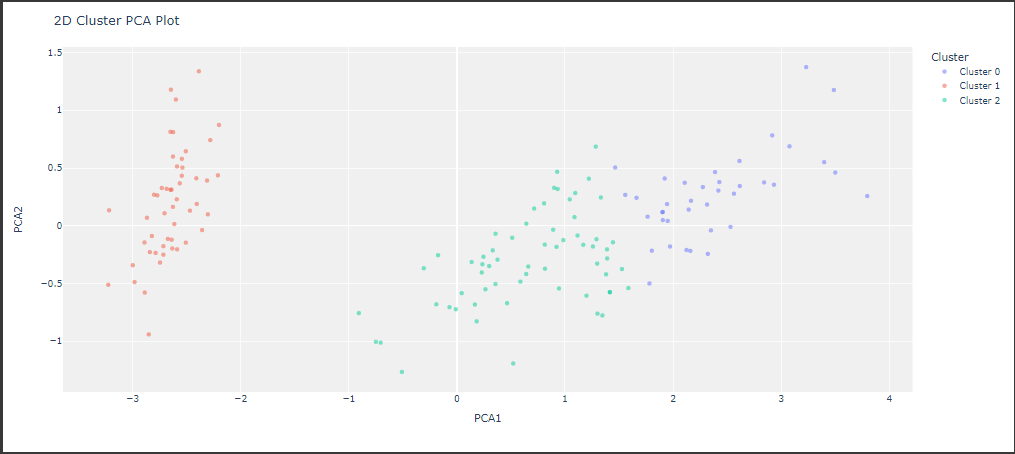

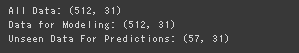

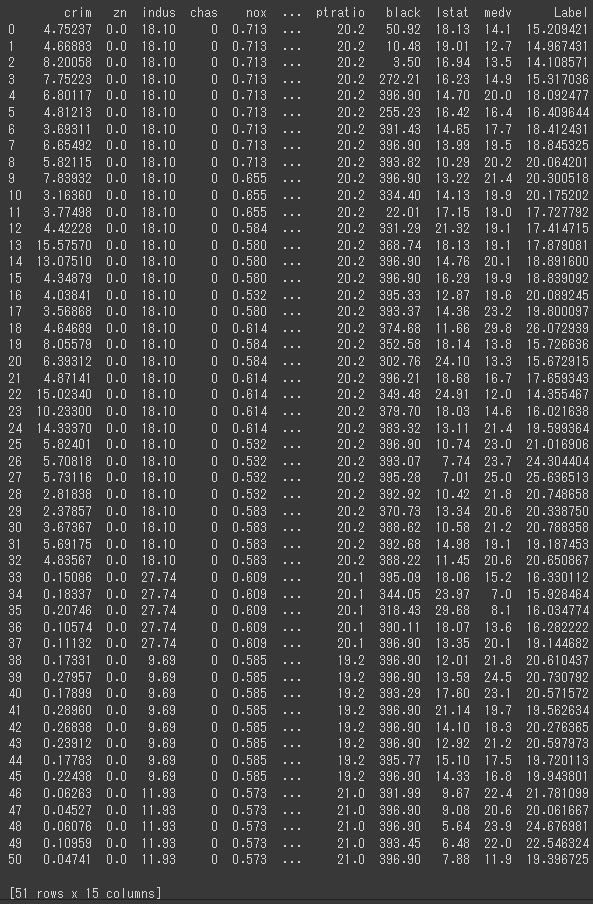

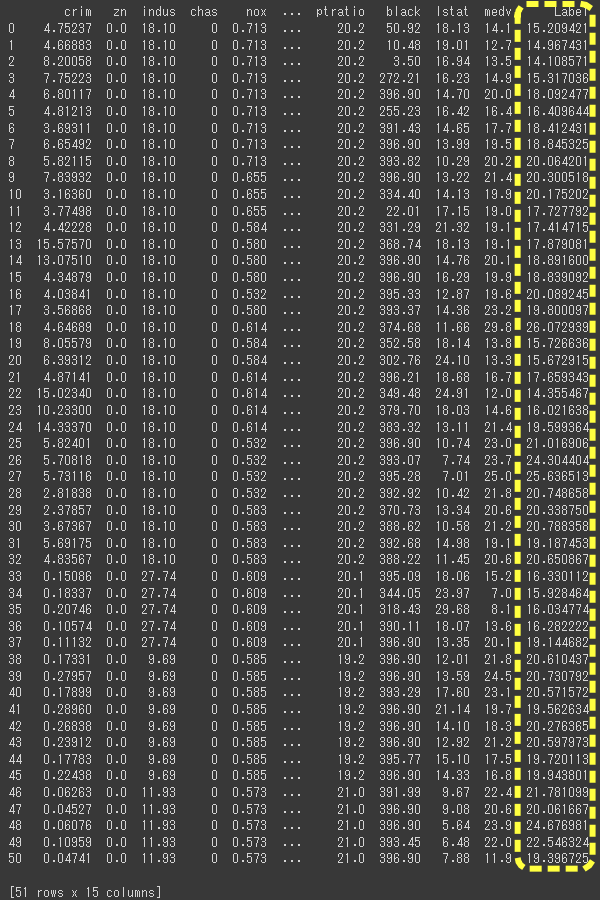

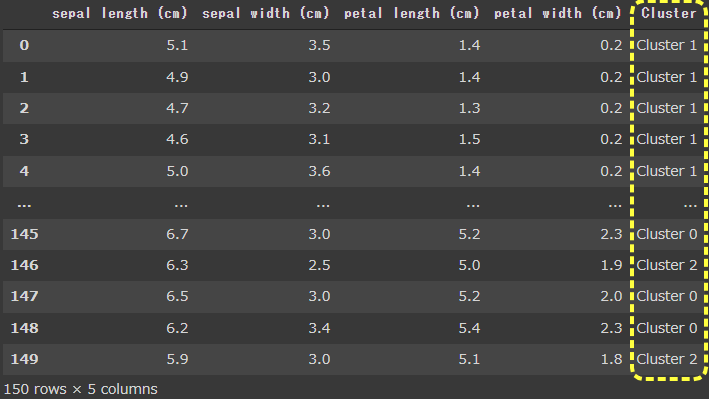

クラスタリング

predict_model関数に、構築したモデルとデータを渡すとクラスタリング(グループ化)を行うことができます。

[Google Colaboratory]

1 | ret = predict_model(kmeans, data=df_iris) |

[実行結果]

クラスタ番号がClusterとして追加されています。

このようにクラスタリングに関しても、複数アルゴリズムでのモデル構築や、エルボー図やシルエット図での評価まで簡単に行うことができました。

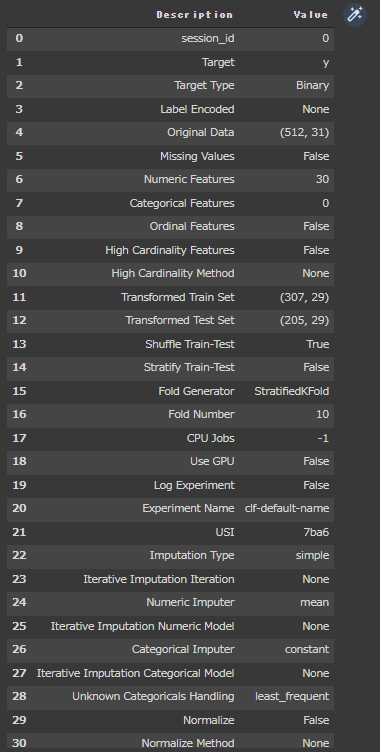

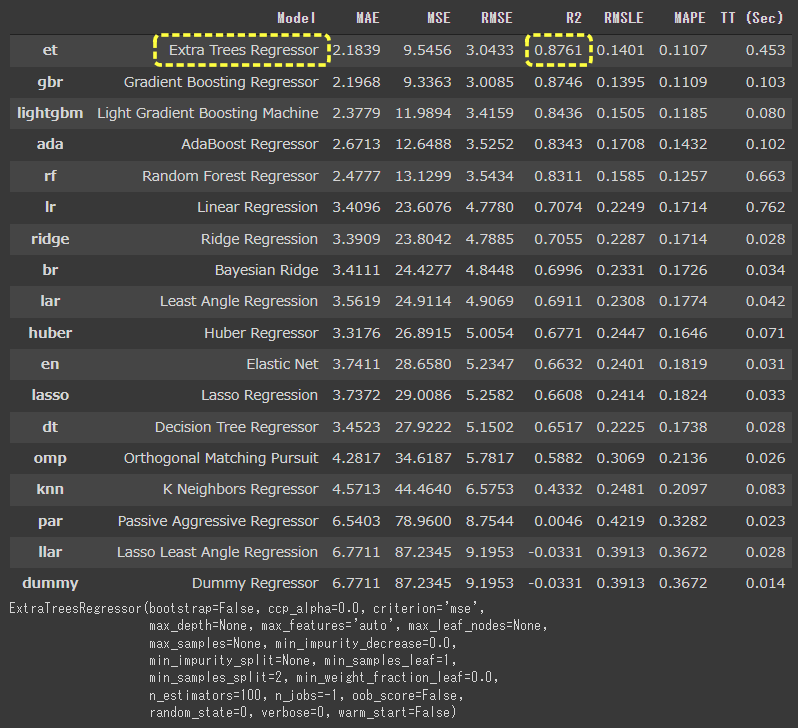

AutoML

AutoMLを使って、非常に短いコードでモデルの構築や評価を行うことができました。

AIモデル構築の分野はますます便利になっていき、より簡単にモデル構築ができるようになってきています。