モデルを評価するために、PyCaretで用意されているいろいろな評価指数グラフを確認してみます。

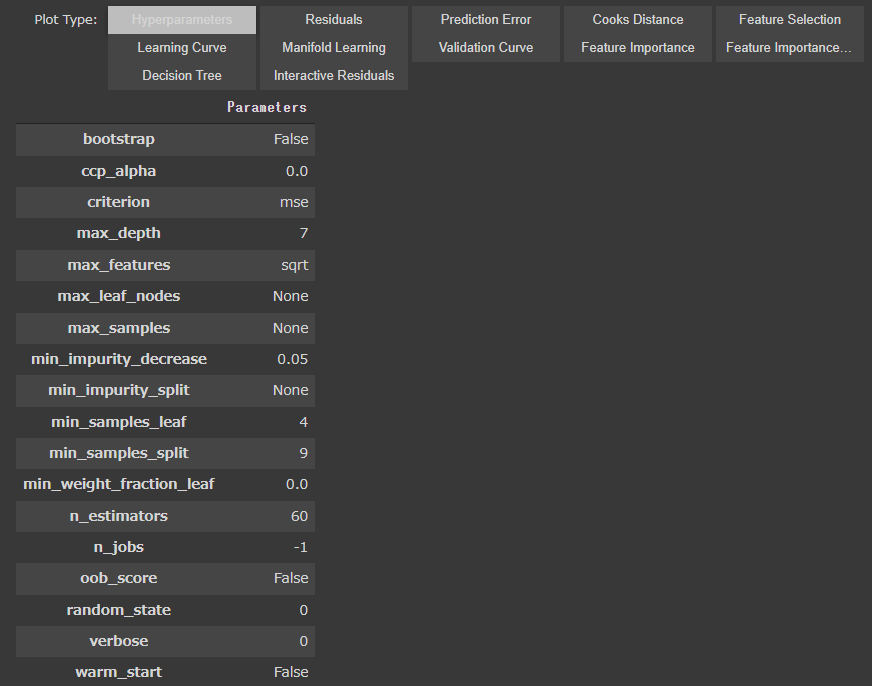

evaluate_modelダイアログ

evaluate_model関数に、モデルを渡して実行するとボタン(PlotType)が表示されます。

[Google Colaboratory]

1 | evaluate_model(tuned_rf) |

PlotTypeを切り替えることで、様々な評価指標を確認することができます。

[実行結果]

初期表示ではハイパーパラメータが表示されています。

個別にグラフを表示することもできるので、代表的な指標を確認していきます。

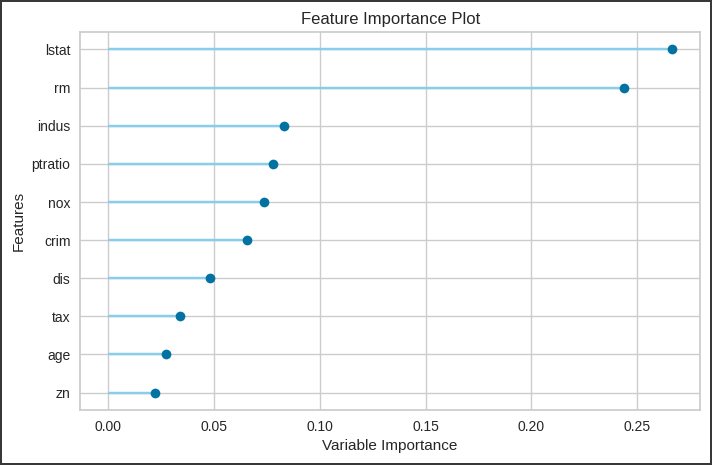

Feature Importance

Feature Importanceでは、説明変数の重要度を確認できます。

[Google Colaboratory]

1 | plot_model(tuned_rf, "feature") |

[実行結果]

目的変数に及ぼす影響が大きい順に、上から表示されています。

LSTATとRMの影響が大きいことが確認できます。

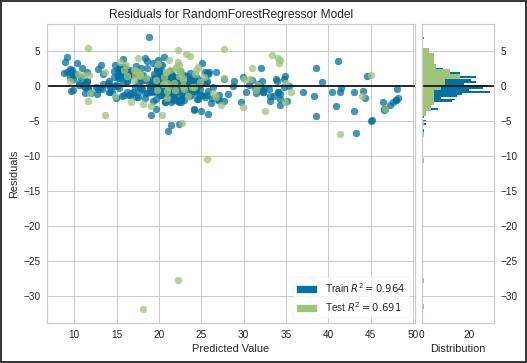

Residuals Plot

Residuals Plotでは、残差プロットを表示します。

[Google Colaboratory]

1 | plot_model(tuned_rf, "residuals") |

[実行結果]

右側にはヒストグラムも表示されて、分かりやすくなっています。

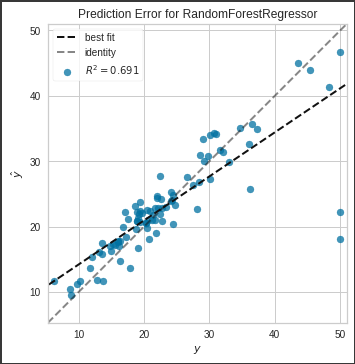

Prediction Error Plot

Prediction Error Plotでは、予測精度を確認できます。

[Google Colaboratory]

1 | plot_model(tuned_rf, "error") |

[実行結果]

identityに対するズレ(予測と実測の誤差)からR2が計算されています

予測と実測が同じ場合は、分布が y = x の直線付近に近づきます。

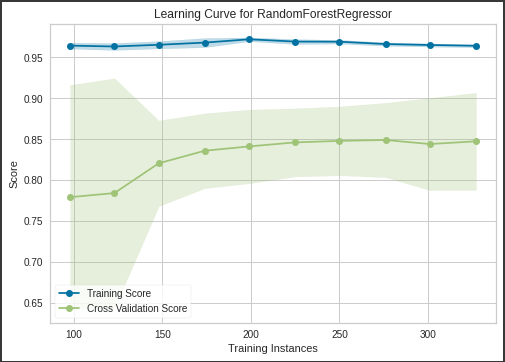

Learing Curve

Learing Curveでは、学習曲線を表示します。

[Google Colaboratory]

1 | plot_model(tuned_rf, "learning") |

[実行結果]

訓練データとテストデータの予測精度が、データ数に対してどのように推移しているのかを確認できます。

Cross Vaidation Scoreにより、交差検証による精度の幅を示しています。

訓練データを増やすと、テストデータの予測精度が上がっていきますが、感度が鈍っていく様子が見てとれます。