機械学習でアヤメの品種を分類します。

機械学習でアヤメの品種分類

scikit-learn には、機械学習やデータマイニングを試すことができるようデータが同梱されています。

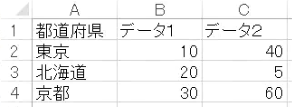

iris.dataには次の4種類のデータが格納されています。

| カラム | 内容 |

|---|---|

| sepal length (cm) | がく片の長さ |

| sepal width (cm) | がく片の幅 |

| petal length (cm) | 花弁の長さ |

| petal width (cm) | 花弁の幅 |

iris.targetには次の3種類の花の種類が格納されています。

| 花の種類 | 値 |

|---|---|

| setosa | 0 |

| versicolor | 1 |

| virginica | 2 |

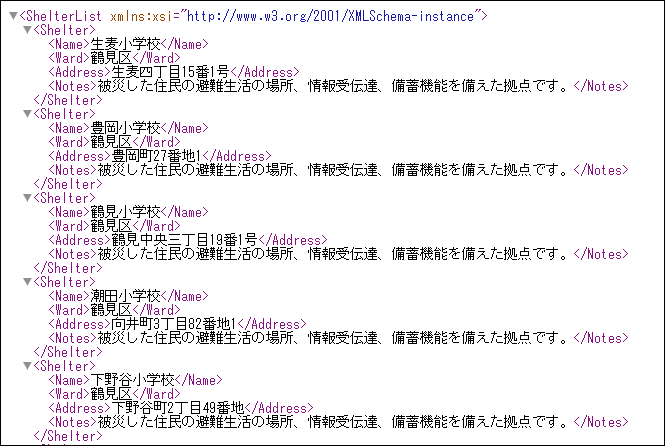

実行するコードは下記の通りです。

[コード]

1 | import pandas as pd |

学習用とテスト用にデータを分離し、シャッフルまで行ってくれるmodel_selection.train_test_split(7行目)はとても便利です。

実行結果は次のようになります。

[実行結果]

正解率: 0.9333333333333333

正答率93%以上と十分な結果となりました。