LightGBMというアルゴリズムを使って、タイタニックの生存予測を行います。

LightGBMは、マイクロソフトが開発したアルゴリズムで次のような特徴があります。

- 決定木ベースの勾配ブースティングを行う

- 精度が高い

- 非常に高速

- 欠損値の補完が不要

- 特徴のスケーリング(例えば最小値0、最大値1に正規化すること)が不要

前処理

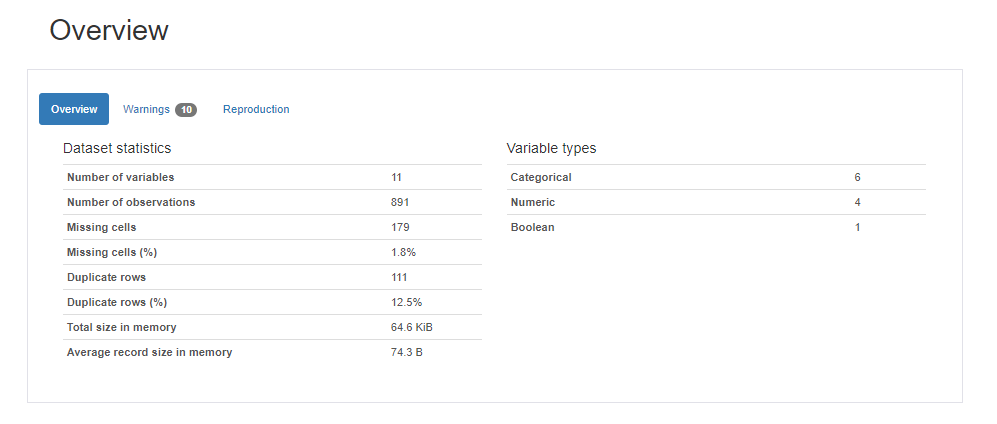

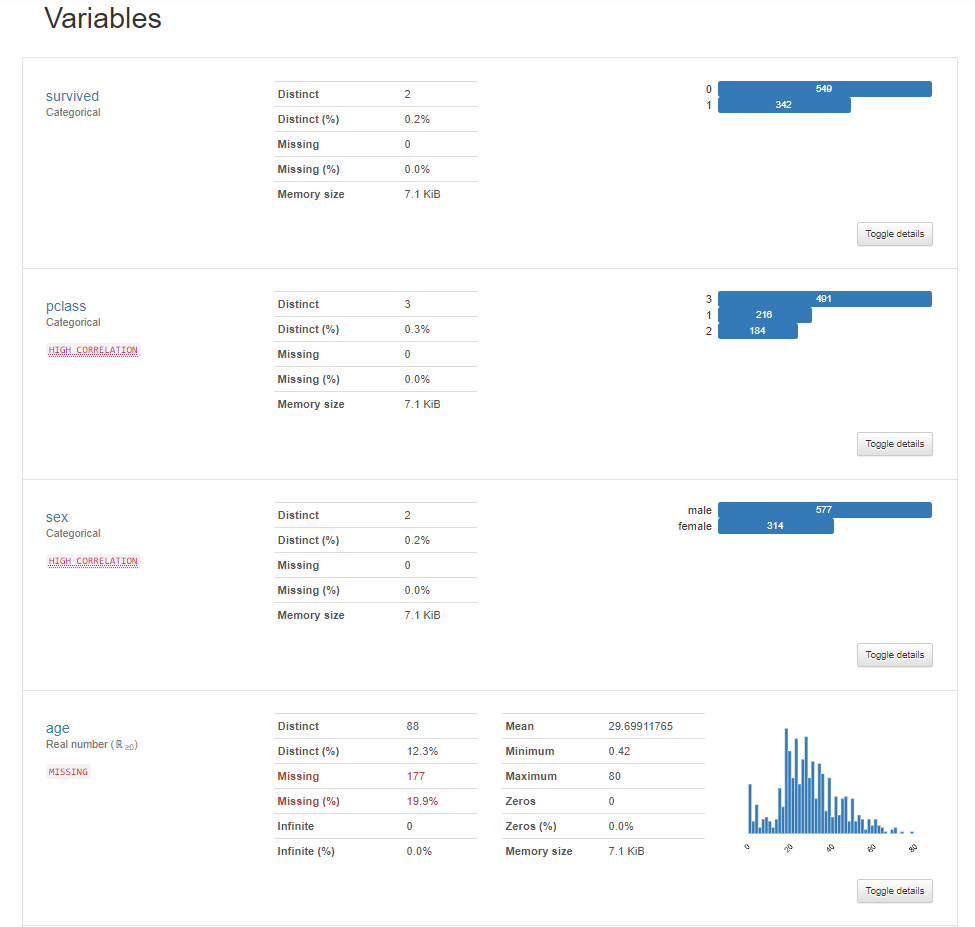

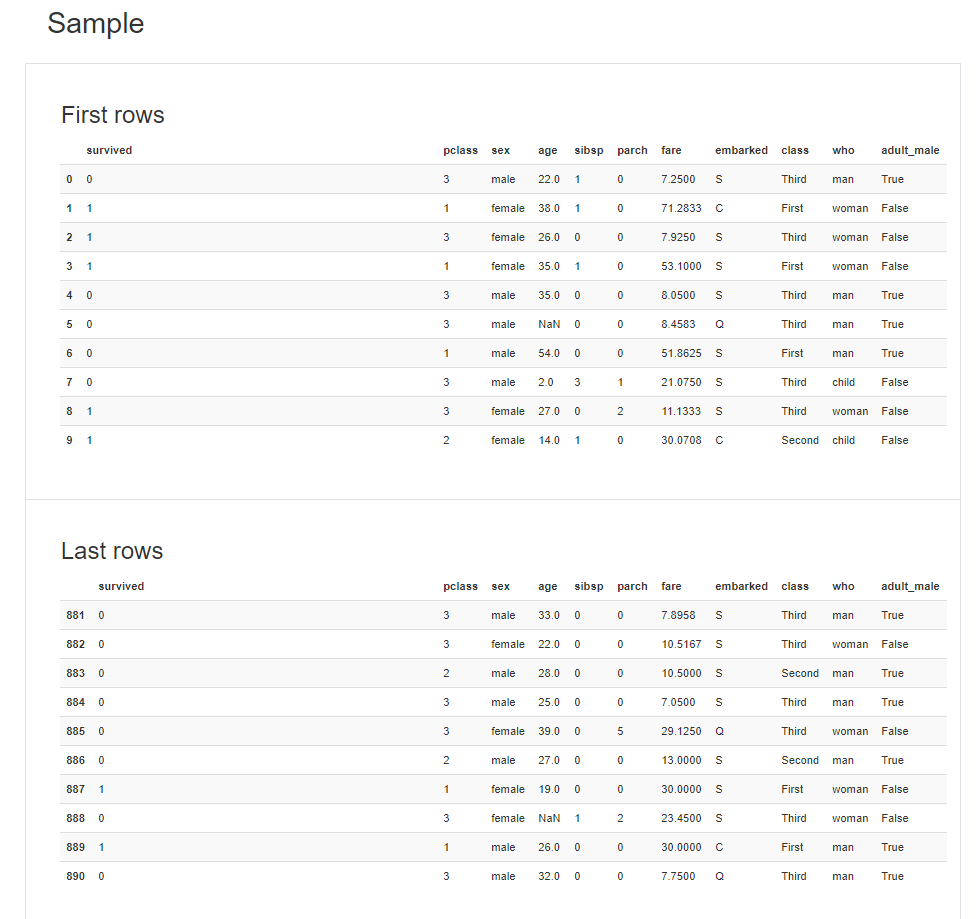

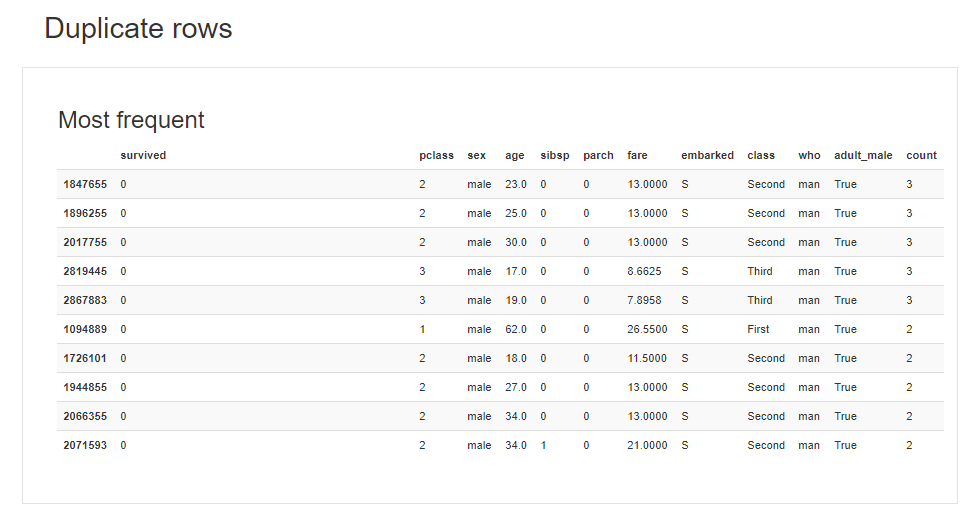

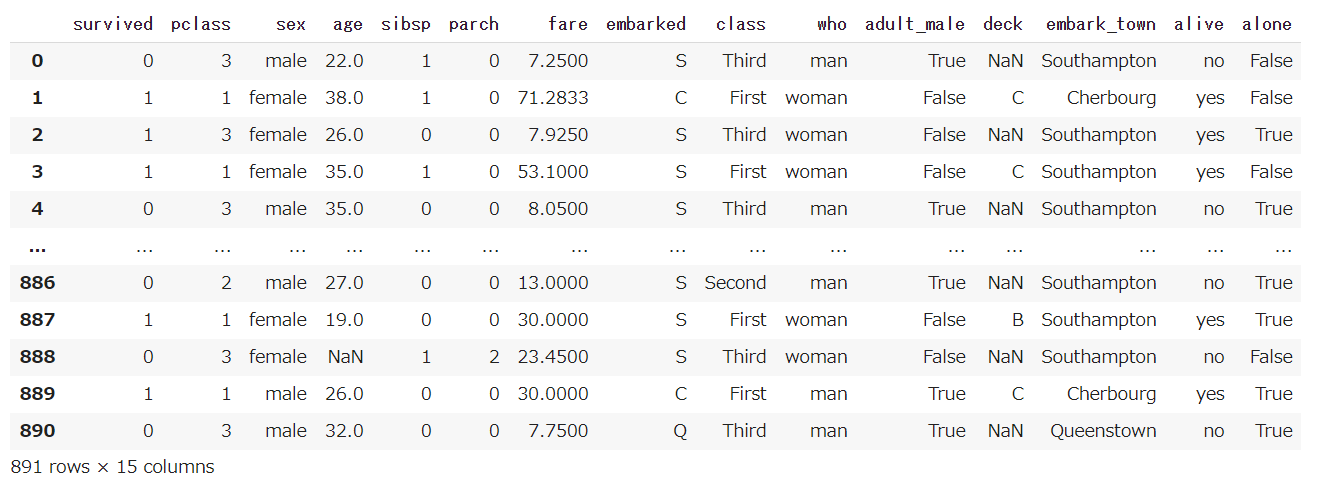

前処理(Preprocessing)では、与えられたデータセットに対してアルゴリズムを用いて予測ができる形式に変換するまでの処理を行います。

具体的には、下記の処理があげられます。

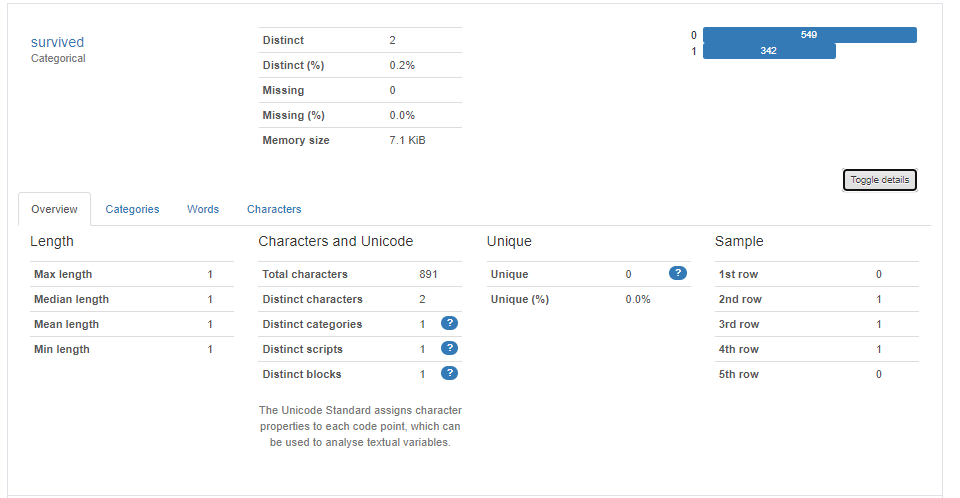

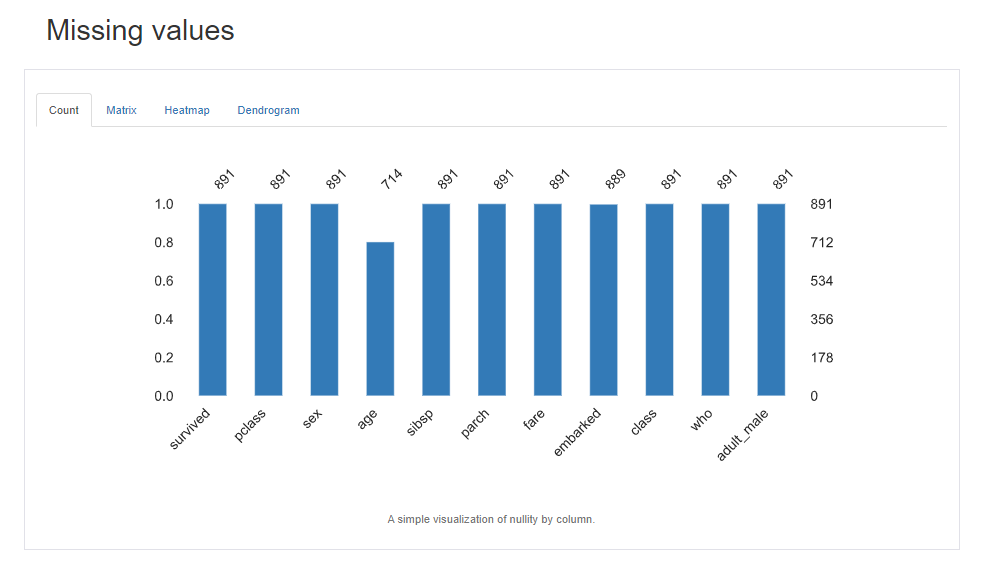

- 欠損値の対応

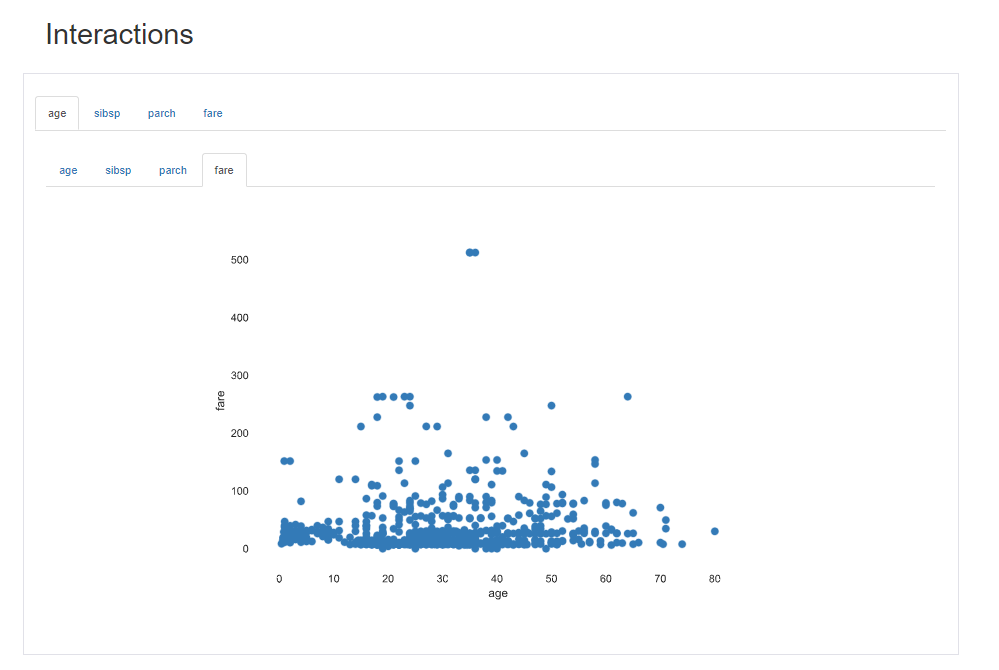

- 外れ値の検出・処理

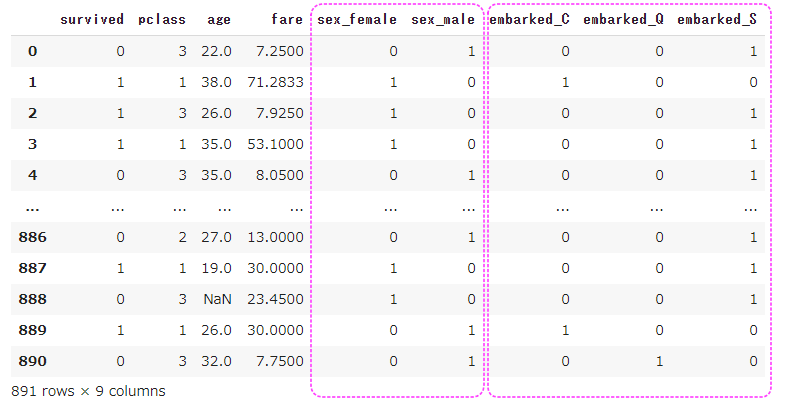

- ダミー変数の作成

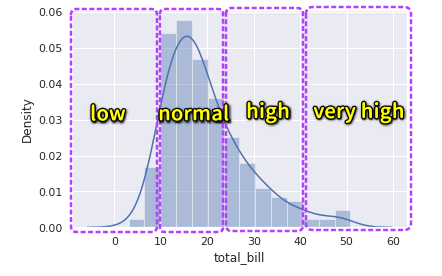

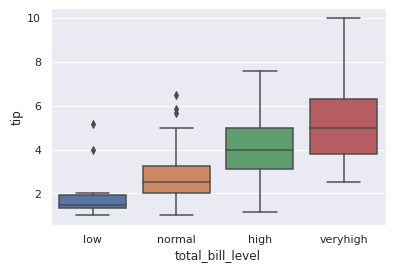

- 連続データの離散化

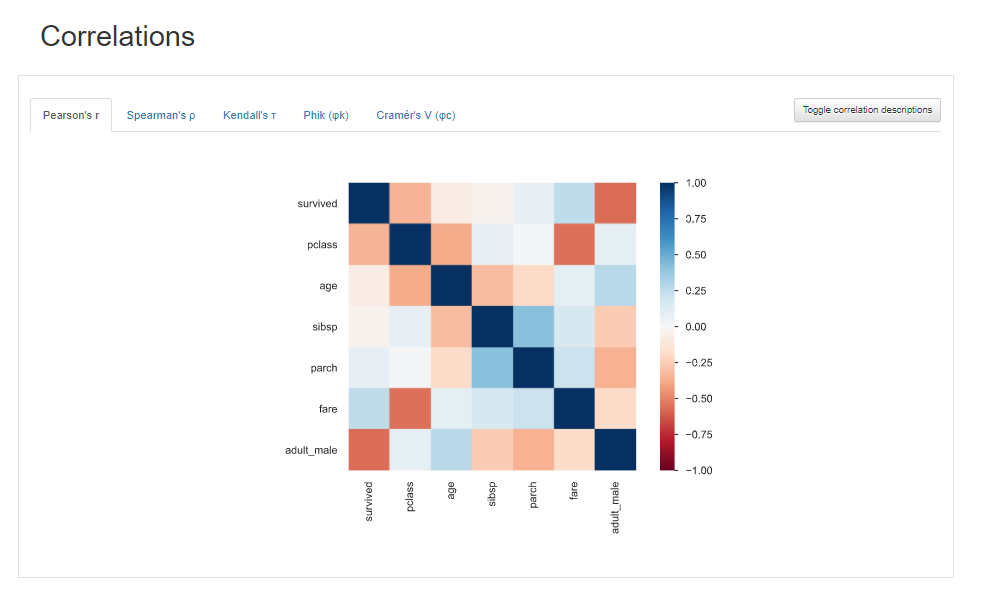

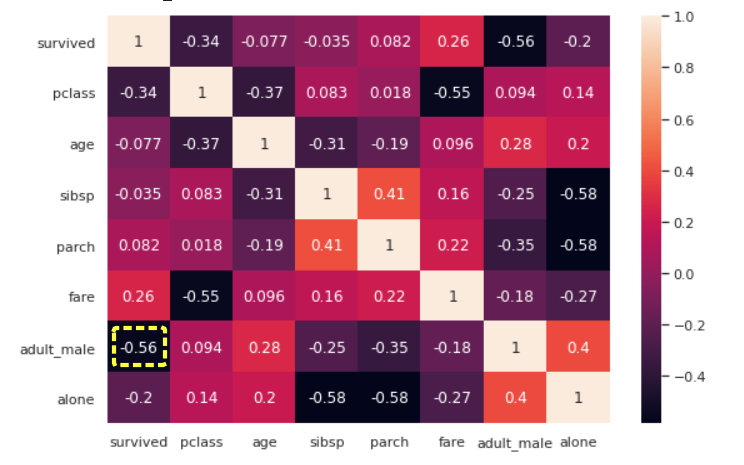

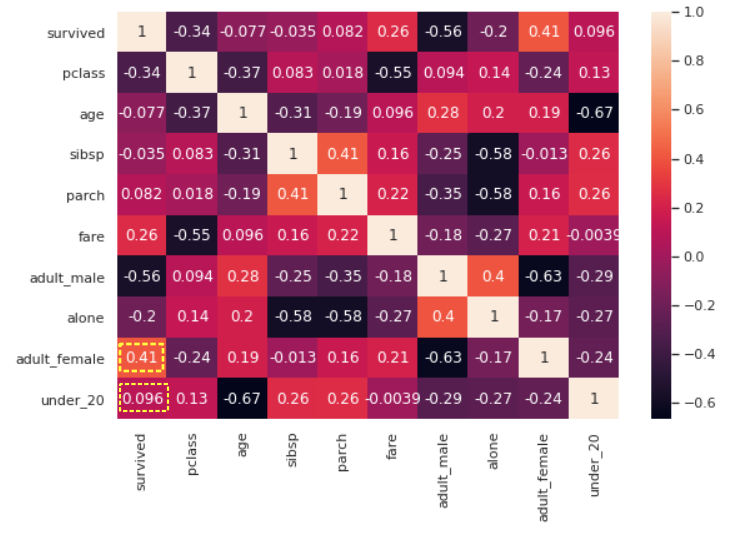

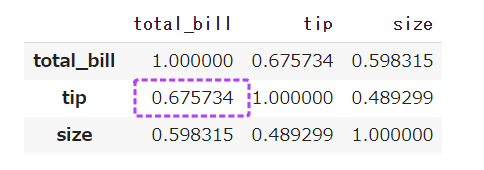

- 特徴量選択

前処理の仕方によって、予測結果が大きく変わってきますのでとても重要であり、多くの時間を費やす作業となります。

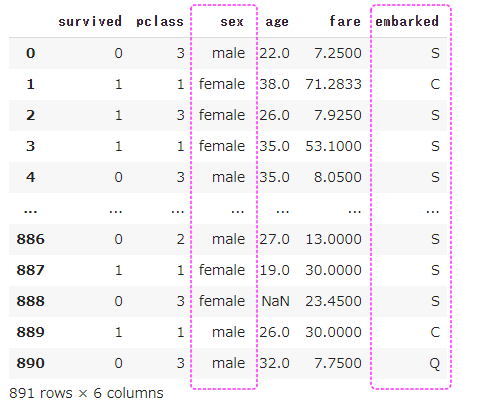

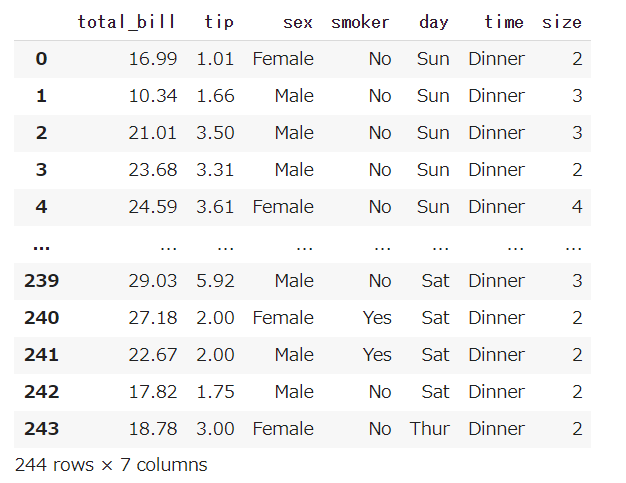

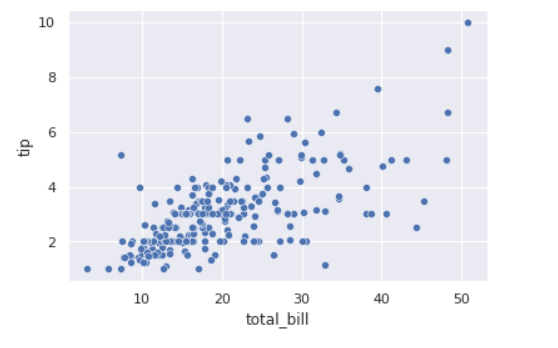

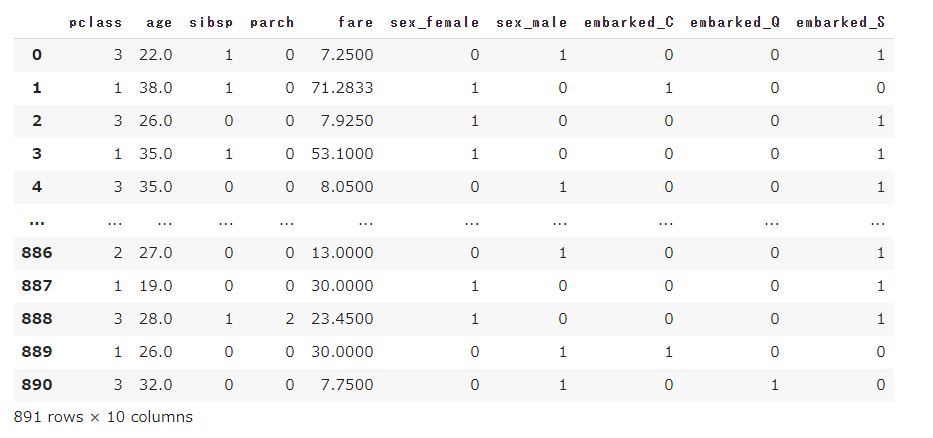

今回は、タイタニックのデータセットに対して、不要列の削除・欠損値処理・カテゴリ変数の変換を行います。

1 | import pandas as pd |

ホールドアウト法での学習

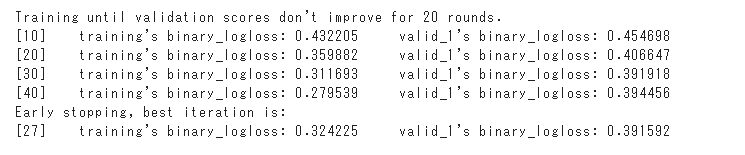

scikit-learnのtrain_test_split関数を用いて、データセットを67%対33%の割合でtrainセット(訓練用)とvalidセット(検証用)に分割し学習を行います。

1 | import lightgbm as lgb |

27roundでlossが最低となり、学習が終了しています。

生存予測

学習したモデルが、validセット(検証用データ)に対してどのくらい予測性能があるか確認します。

1 | # valid_xについて推論 |

約82.7%の正解率で予測できました。

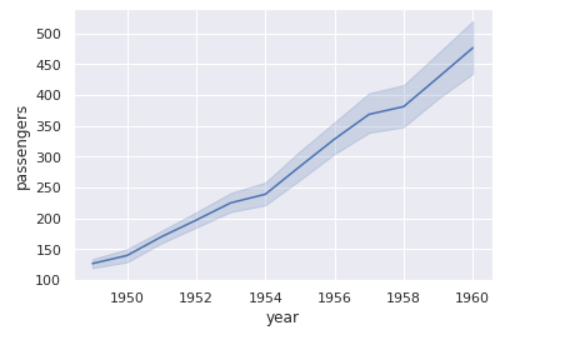

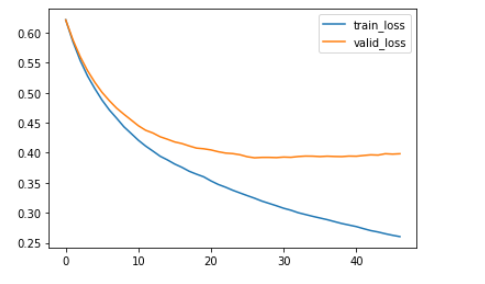

学習の状況が、eval_resultsに格納されているので学習曲線を表示してみます。

1 | import matplotlib.pyplot as plt |

train(訓練)のロスは下がり続けていますが、valid(検証)のロスは20roundあたりから下がりにくくなっています。

ロスが最も少なくなるのが27roundであり、推論はこの27roundで行われます。

predict関数のnum_iterationでroundを指定することができますが、指定しない場合はbestのroundが使われます。

(実行環境としてGoogleさんのColaboratoryを使用ています。)