ベクトル同士の四則演算

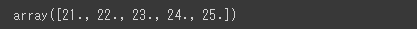

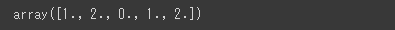

ベクトル同士で四則演算を行うと、同じ次元の成分同士の演算が行われます。

(ブロードキャストの仕組みによって、同じ次元の成分同士で計算されます。)

ベクトル同士の演算を行うためには、次元数が同じであることが条件となります。

次元数が異なるベクトル同士を演算すると、どちらかの成分が余ってしまうのでエラーになります。

[Google Colaboratory]

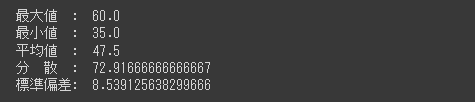

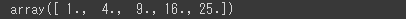

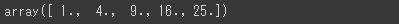

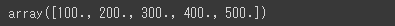

1 | import numpy as np |

[Google Colaboratory]

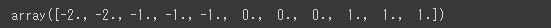

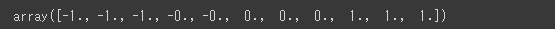

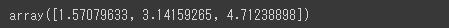

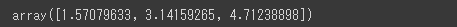

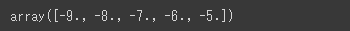

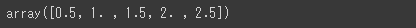

1 | vec1 - vec2 # ベクトル同士の引き算 |

[Google Colaboratory]

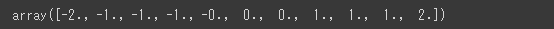

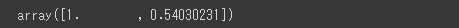

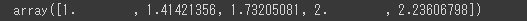

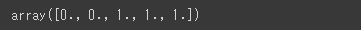

1 | vec1 / vec2 # ベクトル同士の割り算 |

本来、ベクトル同士で割り算は行えませんが、NumPyのndarrayオブジェクトで表現するベクトルは、次元数が同じであればブロードキャストの仕組みが働いて同じ次元の成分同士で割り算が行われます。