DBSCAN(Density-Based Spatial Clustering of Applications with Noise)を使って、クラスタリングを行います。

DBSCANは、密度準拠クラスタリングのアルゴリズムを使います。

密接している点を同じグループにまとめ、低密度領域にある点をノイズ(外れ値)と判定します。

各点は自身の半径以内に点がいくつあるかでその領域をクラスタとして判断するため、クラスタ数をあらかじめ決めなくていいという長所があります。

近傍の密度がある閾値を超えている限り、クラスタを成長させ続け、半径以内にない点はノイズになります。

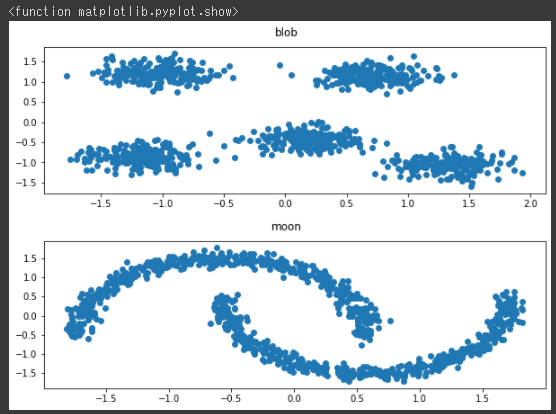

データセットの準備

今回は2種類のデータセットを生成します。

1つ目のデータセットとして塊データを生成し、可視化します。(1~9行目)

2つ目のデータセットとしてムーンデータを生成し、可視化します。(11~19行目)

[Google Colaboratory]

1 | X = datasets.make_blobs(n_samples=1000, random_state=10, centers=5, cluster_std=1.2)[0] |

[実行結果]

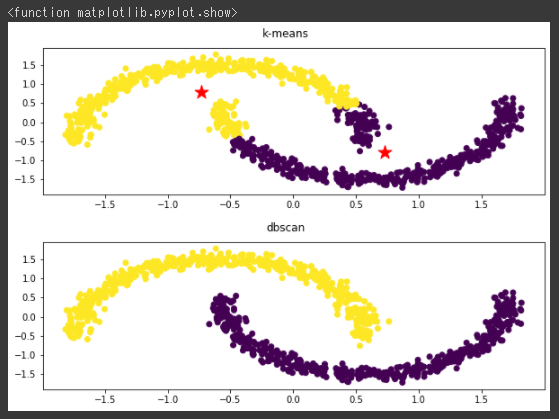

ムーンデータをクラスタリング

まずk-meansのクラスタリング結果を可視化し(1~7行目)、その後にDBSCANでクラスタリングを行ってから同じく可視化しています(9~14行目)。

DBSCANモデルはcluster.DBSCAN関数で作成しします。(9行目)

[Google Colaboratory]

1 | km_moon = cluster.KMeans(n_clusters=2) |

[実行結果]

k-meansではうまく分類できていませんが、DBSCANだときちんと分類されています。

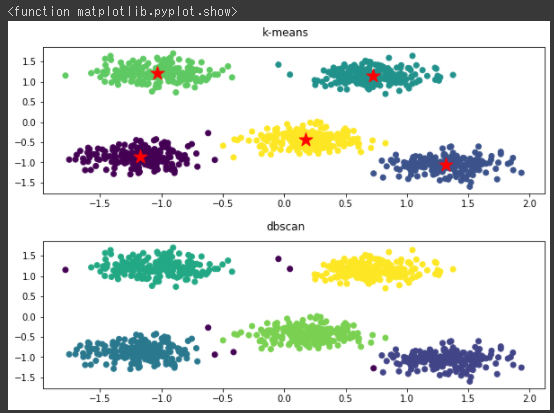

塊データをクラスタリング

塊データもk-meansとDBSCANでクラスタリングを行ってみます。

[Google Colaboratory]

1 | km=cluster.KMeans(n_clusters=5) |

[実行結果]

今回は両方のアルゴリズムでうまく分類できているようです。

DBSCANは、データの密度を基準とするアルゴリズムで、全データ点はコア点、到達可能点、ノイズ点に分類されます。

8行目のepsパラメータで決められた半径内にmin_samplesパラメータの値以上の点が集まっていれば、それをコア点であると判断します。

コア点ではないデータでも、近くにあるコア点からeps半径の中に入っているものは到達可能点であると判断します。

そのどちらにもなれなかった点はノイズ点(外れ値)として分類されます。

DBSCANにおいて、epsとmin_samplesはとても重要なパラメータだということになります。

DBSCANの総括

DBSCANは球の形状を前提とせず、ノイズ分類もできて、クラスタ数の指定も必要ないクラスタリングになります。

デメリットとしては、全データ点を対象とした反復計算を実施しているため計算コストが高く、リアルタイム性が求められるよな場合には不向きです。

またデータが密集しているとパラメータ調整が難しくなるという一面もあります。