Win10を高速化するテクニックを3つご紹介します。

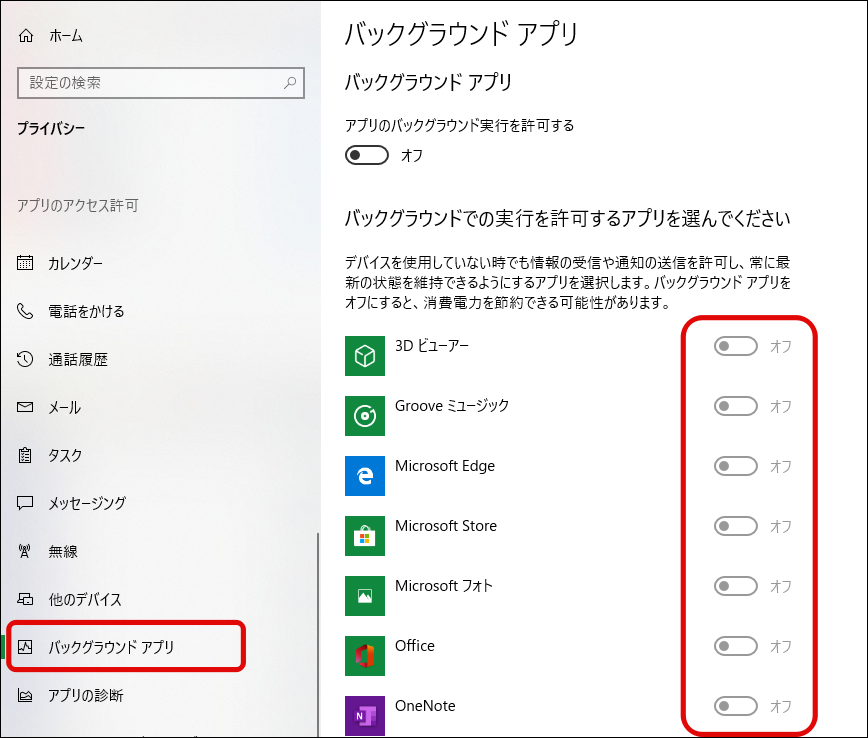

(1)バッググラウンドアプリの停止

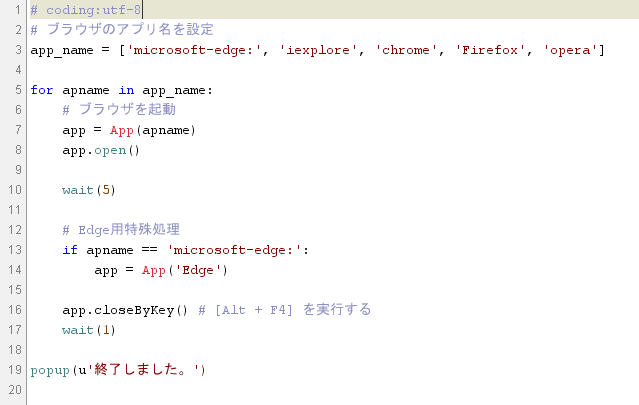

まず1つめはバックグラウンドアプリの停止です。(もっとも効果の高い方法の1つだと思われます。)

不必要なソフトがバックグラウンドで動作していると無駄なので不要なものはオフにしておきましょう。

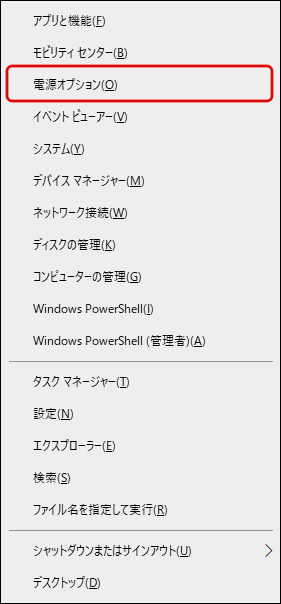

手順1

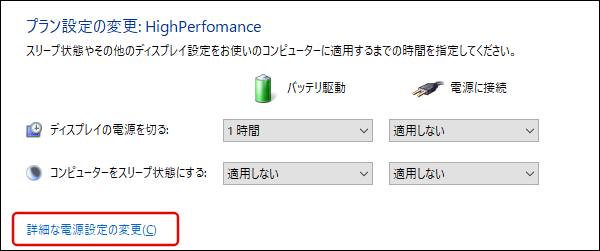

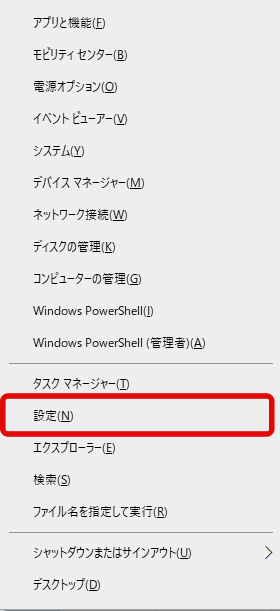

[Win] + [x]を押して表示されるメニューで[設定]をクリックします。

手順2

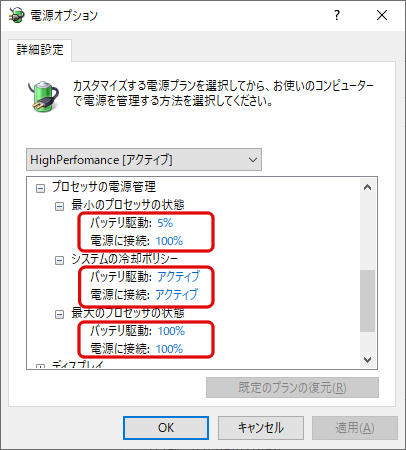

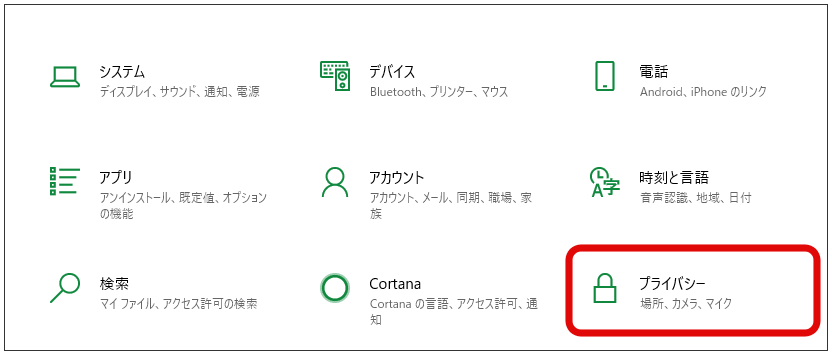

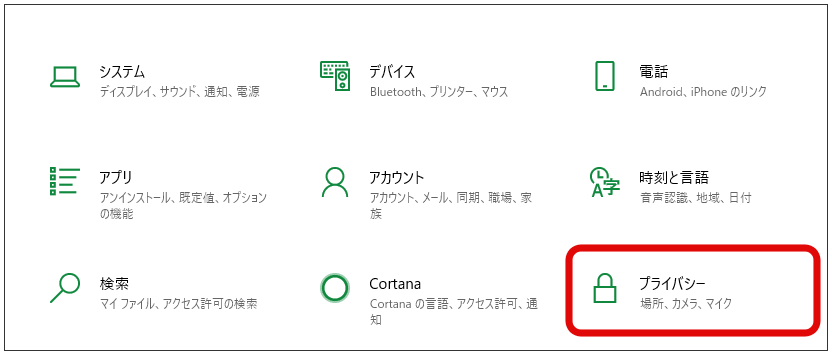

Windowsの設定画面で[プライバシー]をクリックします。

手順3

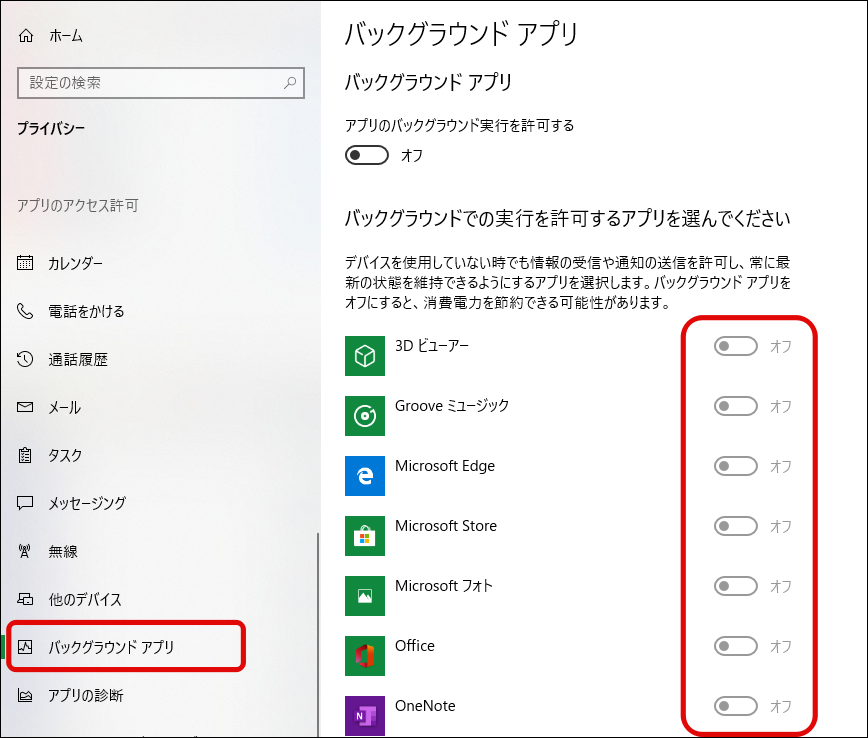

左側のメニューから[バックグラウンド アプリ]を選択し、次に右の画面から不要なアプリをオフにします。(ちなみに私は全てオフにしています。特に問題は起きていません。)

(2)パソコン起動時に同時に起動されるアプリ(スタートアップアプリ)を減らす

起動時に自動起動されるソフトが多いと、パソコンの起動に時間がかかってしまいます。

スタートアップアプリを整理することでパソコン起動の時間を速くすることができます。

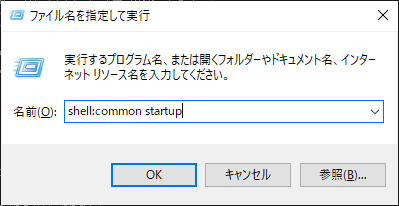

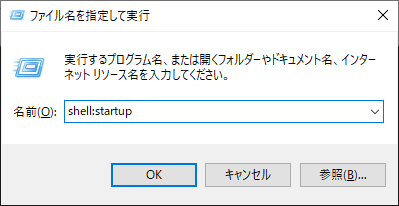

手順1

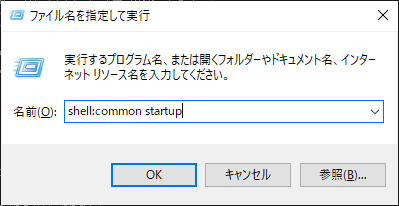

[Win] + [r]を押して[ファイル名を指定して実行]を表示してから[shell:common startup]と入力し、[OK]ボタンをクリックします。

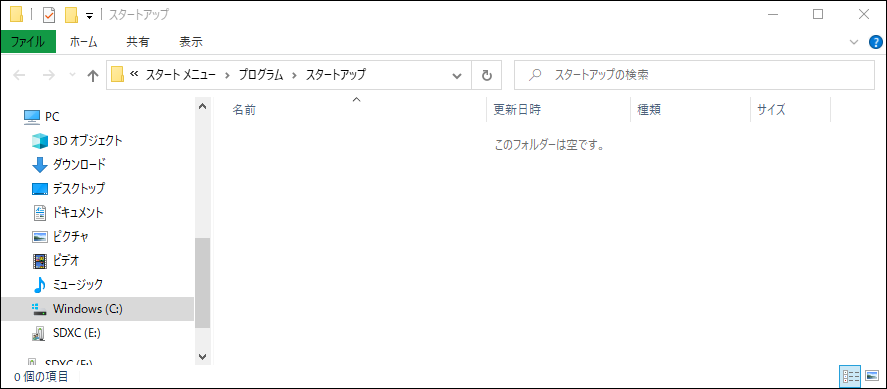

手順2

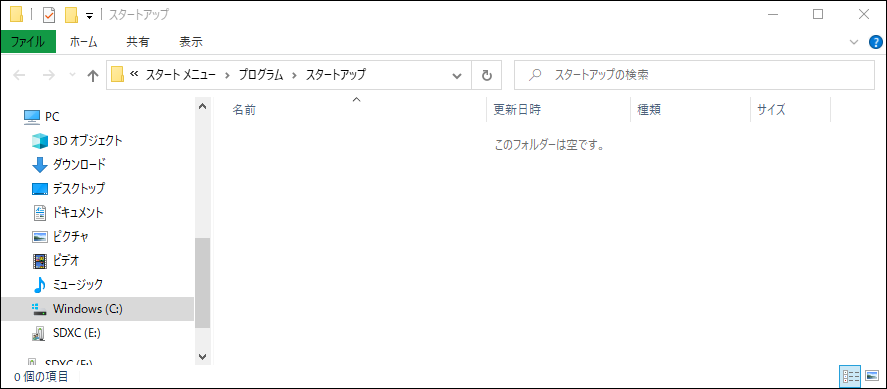

[スタートアップ]というタイトルのフォルダが表示されるので、自動起動する必要のないファイルを削除します。(私の環境ではすでに全て削除されている状態になってました。)

上記の手順1~2で行ったのは全ユーザ共通のスタートアップ(自動起動)アプリとなります。

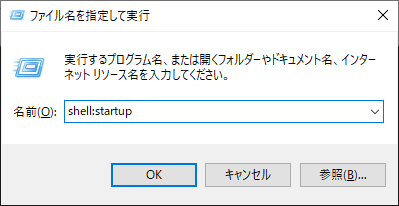

ユーザごとのスタートアップを削除するには手順1のところで[shell:startup]を入力し、同様に不要なスタートアップアプリを削除します。

(3)スタートアップにない自動起動ソフトを減らす

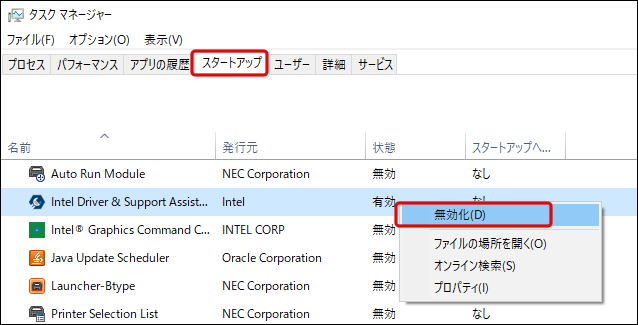

Windowsではスタートアップ以外にも自動起動ソフトが設定されていて、タスクマネージャーを使って自動起動を無効化することができます。

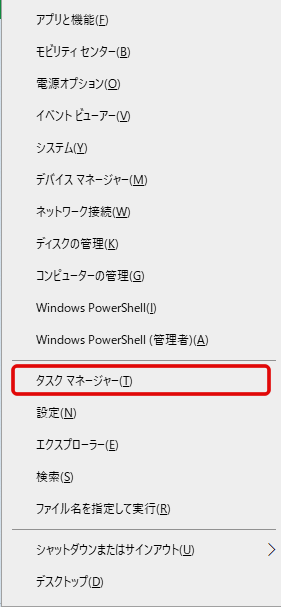

手順1

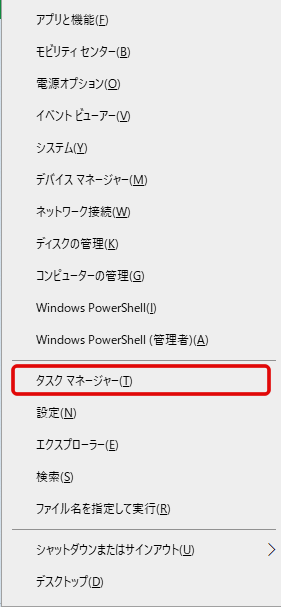

[Win] + [x]を押して表示されるメニューで[タスクマネージャー]をクリックします。

手順2

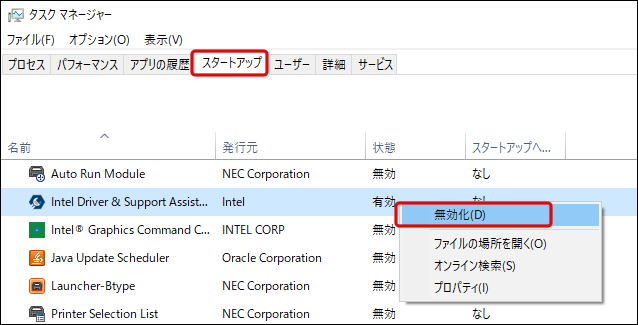

[スタートアップ]タブを選択し、自動起動が不要なソフトを右クリックし[無効化]を選択します。(よくわからないソフトは無効化しない方が無難ですが、試しに一度無効化して問題あったら有効に戻すということもできます。)