SikuliのOCR機能と状態変化を検知する機能を使って、画面に表示されている為替レートの変化を常時監視してみます。

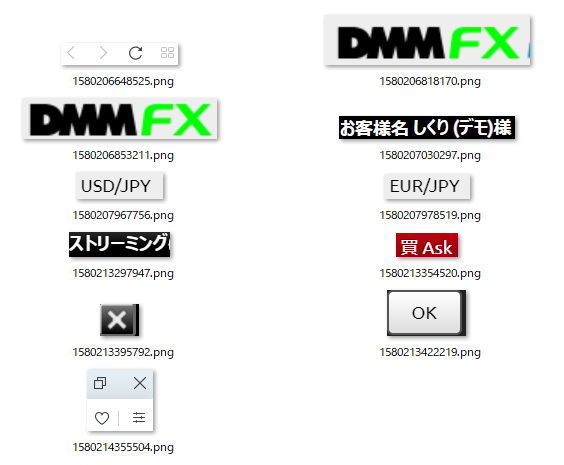

まずOCRに関しては、Regionクラスのtextメソッドで数字くらいなら簡単に認識してくれます。

画面変化を検知するのは少し難しいのですが、変化検知したときに動作する関数をRegionに設定しておく感じとなります。

今回はhandler1関数を定義し、OCRで取得した数字をエディタに貼り付けてみます。

Regionへのイベントハンドラ追加にはonChangeメソッドを使い、第1引数にはどれだけ変化があったらイベントハンドラを呼び出すかを指定します。今回は10を指定したので10ピクセル以上変化したらイベントハンドラがコールされます。

状態検知を有効にするためにはobserve関数を使うのですが、この関数を使うと処理が止まってしまうので通常はobserveInBackground関数を使いバックグラウンドで状態検知を有効にします。

また、処理を終了するときにはstopObserver関数を使い、状態検知を無効にします。

1 | # coding:utf-8 |

この処理の動きは下記の動画で確認していますので、参考にして頂ければ幸いです。

OCRと状態変化検知を使うと、投資対象の為替レートを常時監視ができるようになり、例えば一定時間にある程度上昇したらその上昇に合わせて順張り投資するといったことが可能になります。

パラダイムシフトの時のような急激な一方方向へのトレンドがある場合は、順張り+建玉追加投資できるとかなりの利益を上げることができますが、そんなトレンドを人が張り付いて確認し続けるのは大変なので今回実装したようなRPAでの処理をうまく活用したいものです。