前回までは、ウォード法でクラスタリングを行ってきましたが、今回は最短距離法を使ってクラスタリングをします。

データセットの準備

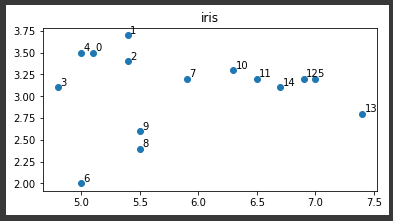

まずscikit-learnのアヤメのデータセットを読み込みます。

比較しやすくするために、サンプル数を10分の1に減らします。(4行目)

最後に散布図に表示します。(10行目)

[Google Colaboratory]

1 | from sklearn.datasets import load_iris |

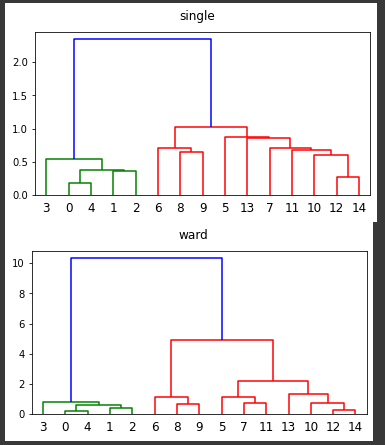

最短距離法とウォード法の比較

最短距離法とウォード法の両方でクラスタリングを行い、それぞれの樹形図を表示します。

最短距離法ではパラメータmethodに“single”を指定(1行目)し、ウォード法では“ward”を指定(7行目)します。

[Google Colaboratory]

1 | Z = linkage(X, method="single", metric="euclidean") |

結果はほとんど変わっていないようですが、5,13,7,11の分類が少し異なっています。

最短距離法のメリットは計算量が少ないことです。

ただ鎖効果(ある1つのクラスタに対象が1つずつ順番に吸収されながらクラスタが形成されること)のために、クラスタが帯状になり分類感度が低いことがデメリットになります。