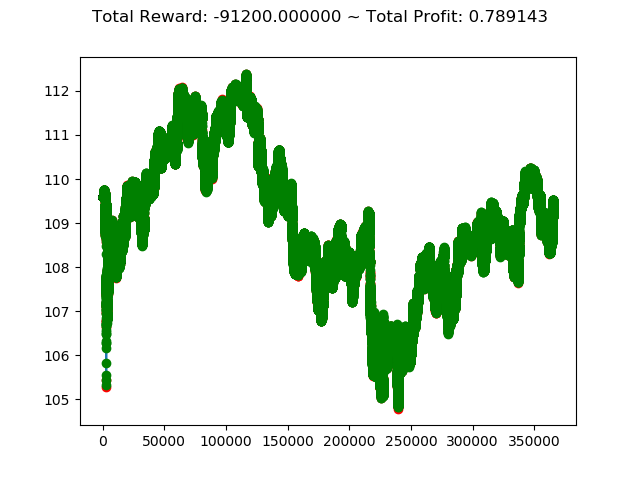

今回は、2018年のデータで学習を行い、2019年のデータで検証してみます。

2018年で学習し2019年で検証

パラメータとしては、これまで同様に学習アルゴリズム PPO2 で参照すべき直前データを 100 としています。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

| import os, gym

import gym_anytrading

import matplotlib.pyplot as plt

from gym_anytrading.envs import TradingEnv, ForexEnv, StocksEnv, Actions, Positions

from gym_anytrading.datasets import FOREX_EURUSD_1H_ASK, STOCKS_GOOGL

from stable_baselines.common.vec_env import DummyVecEnv

from stable_baselines import PPO2

from stable_baselines import ACKTR

from stable_baselines.bench import Monitor

from stable_baselines.common import set_global_seeds

# ログフォルダの生成

log_dir = './logs/'

os.makedirs(log_dir, exist_ok=True)

# 2018年1月最初のインデックス

idx1 = 5981180

# 2019年1月最初のインデックス

idx2 = 6346695

# 2018年1月最初から2018年12月最後のデータ数

span = idx2 - idx1

# 環境の生成

env = gym.make('forex-v0', frame_bound=(idx1, idx2), window_size=100)

env = Monitor(env, log_dir, allow_early_resets=True)

# シードの指定

env.seed(0)

set_global_seeds(0)

# ベクトル化環境の生成

env = DummyVecEnv([lambda: env])

# モデルの生成

model = PPO2('MlpPolicy', env, verbose=1)

#model = ACKTR('MlpPolicy', env, verbose=1)

# モデルの読み込み

# model = PPO2.load('trading_model')

# モデルの学習

model.learn(total_timesteps=128000)

# モデルの保存

model.save('trading_model')

# モデルのテスト

env = gym.make('forex-v0', frame_bound=(idx2, idx2 + span), window_size=100)

env.seed(0)

state = env.reset()

while True:

# 行動の取得

action, _ = model.predict(state)

# 1ステップ実行

state, reward, done, info = env.step(action)

# エピソード完了

if done:

print('info:', info)

break

# グラフのプロット

plt.cla()

env.render_all()

plt.show()```

<h2> <span class="label label-success">FXトレードを実行</span> </h2>

上記コードを実行すると次のような結果になります。

[コンソール出力]

|

info: {‘total_reward’: -91199.9999999869,

‘total_profit’: 0.7891427171172003,

‘position’: 1}

<br>

<center>

</center>

<br>

今回の成績を含めて、これまでの投資成績を表にまとめると次のようになります。

<br>

<table class="table table-striped table-bordered">

<tr class="success"><th></th><th>学習データ</th><th>検証データ</th><th>トータル報酬</th><th>トータル収益</th></tr>

<tr><td>(今回の結果)</td><td><b>2018年</b></td><td><b>2019年</b></td><td align="right"><b>-91,199</b></td><td align="right"><b>0.7891</b></td></tr>

<tr><td></td><td>2016年</td><td>2017年</td><td align="right">-138,300</td><td align="right">0.6932</td></tr>

<tr><td></td><td>2015年</td><td>2016年</td><td align="right">198,100</td><td align="right">0.9675</td></tr>

<tr><td></td><td>2014年</td><td>2015年</td><td align="right">-59200</td><td align="right">0.7990</td></tr>

<tr><td></td><td>2013年</td><td>2014年</td><td align="right">-179,400</td><td align="right">0.7486</td></tr>

<tr><td></td><td>2012年</td><td>2013年</td><td align="right">176,799</td><td align="right">0.9825</td></tr>

<tr><td></td><td>2011年</td><td>2012年</td><td align="right">85,399</td><td align="right">0.9991</td></tr>

<tr><td></td><td>2010年</td><td>2011年</td><td align="right">-10,000</td><td align="right">0.7218</td></tr>

</table>

<br>

今回は、トータル収益 <b>-91,199</b> とまたマイナスとなってしまいました。

2011年~2019年と比較をしてきましたが、現状3勝5敗という結果になりました。

ちょっと成績がよくないので次回からは違う方向での検証を行っていきたいと思います。