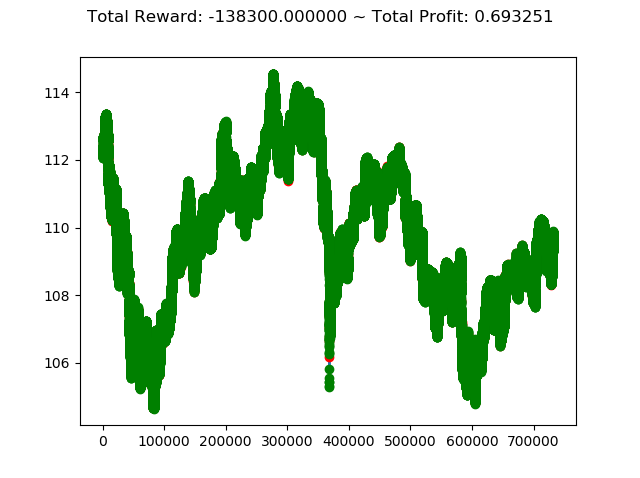

今回は、2016年のデータで学習を行い、2017年のデータで検証してみます。

2016年で学習し2017年で検証

パラメータとしては、これまで同様に学習アルゴリズム PPO2 で参照すべき直前データを 100 としています。

1 | import os, gym |

info: {‘total_reward’: -138300.0000000881,

‘total_profit’: 0.693251225650117,

‘position’: 1}

<br>

<center>

</center>

<br>

今回の成績を含めて、これまでの投資成績を表にまとめると次のようになります。

<br>

<table class="table table-striped table-bordered">

<tr class="success"><th></th><th>学習データ</th><th>検証データ</th><th>トータル報酬</th><th>トータル収益</th></tr>

<tr><td>(今回の結果)</td><td><b>2016年</b></td><td><b>2017年</b></td><td align="right"><b>-138,300</b></td><td align="right"><b>0.6932</b></td></tr>

<tr><td></td><td>2015年</td><td>2016年</td><td align="right">198,100</td><td align="right">0.9675</td></tr>

<tr><td></td><td>2014年</td><td>2015年</td><td align="right">-59200</td><td align="right">0.7990</td></tr>

<tr><td></td><td>2013年</td><td>2014年</td><td align="right">-179,400</td><td align="right">0.7486</td></tr>

<tr><td></td><td>2012年</td><td>2013年</td><td align="right">176,799</td><td align="right">0.9825</td></tr>

<tr><td></td><td>2011年</td><td>2012年</td><td align="right">85,399</td><td align="right">0.9991</td></tr>

<tr><td></td><td>2010年</td><td>2011年</td><td align="right">-10,000</td><td align="right">0.7218</td></tr>

</table>

<br>

今回は、トータル収益 <b>-138,300</b> となりました。

2011年~2017年と順次比較をしてきましたが、現状3勝4敗という結果になっています。